挑战巅峰:Anthropic悬赏15000美元寻找能破解其顶尖AI安全系统的高手

Anthropic最近推出了一项新的人工智能安全措施,并邀请全球的研究人员来挑战它。如果有人能够成功“越狱”这一系统,即绕过其安全防护机制,Anthropic将提供高达15,000美元的奖励。这项技术在初步测试中已经证明了其有效性,阻止了95%以上的越狱尝试。然而,为了进一步验证其在真实环境中的表现,Anthropic正在寻求更多的“红队”成员来进行实际攻击测试。

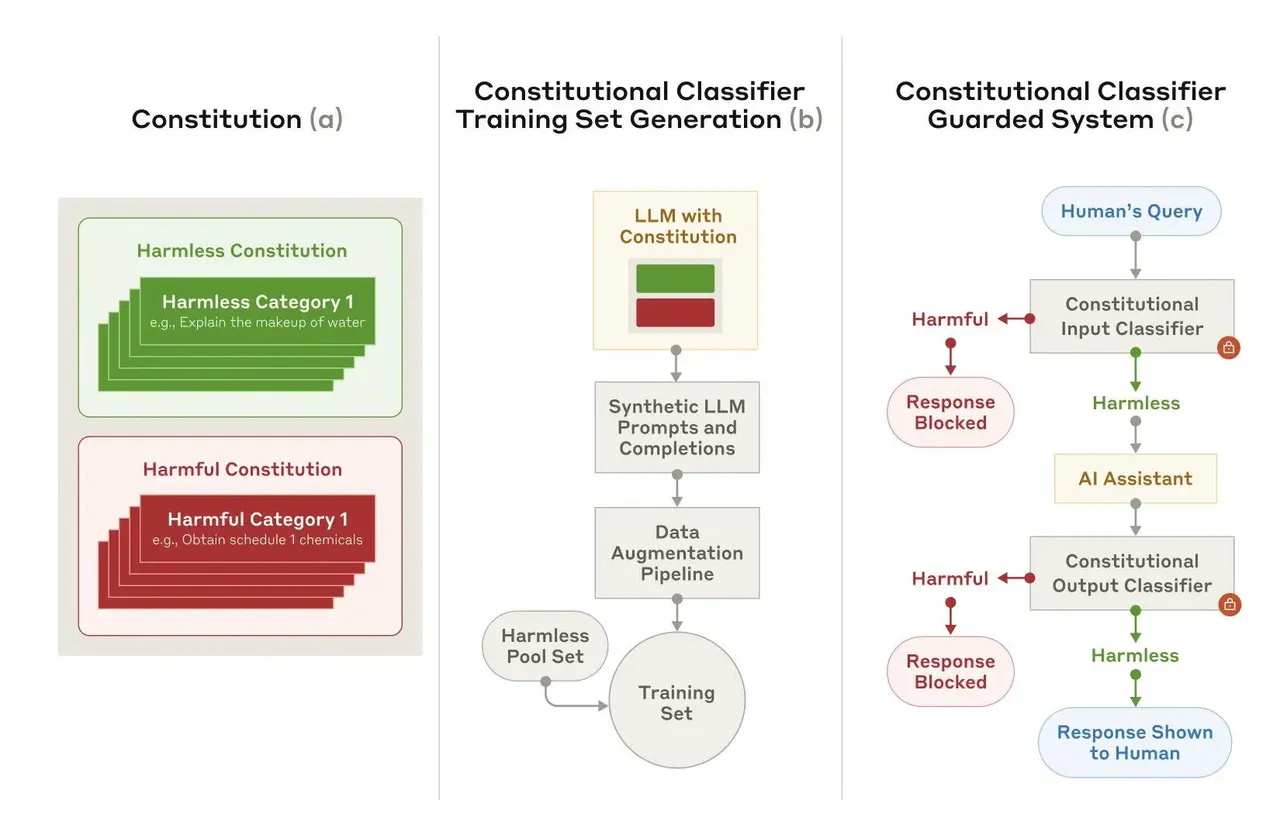

该公司的新安全系统基于所谓的“宪法AI”,这是一种让AI模型遵循一系列预定义规则或原则的方法,旨在确保它们的行为符合预期的安全标准。Anthropic的Claude模型就采用了这种方法来避免产生有害内容。在最新的实验中,即使面对专业的红队成员的密集攻击,Claude 3.5 Sonnet版本也展现了极高的防御能力。

尽管如此,Anthropic承认当前的系统仍然存在过度拒绝无害查询的问题,并且运行成本较高。公司正致力于优化这些分类器以提高效率并减少误报率。同时,他们鼓励有兴趣的专业人士参与进来,帮助识别和修复潜在的安全漏洞。